AiHubMix

详细说明

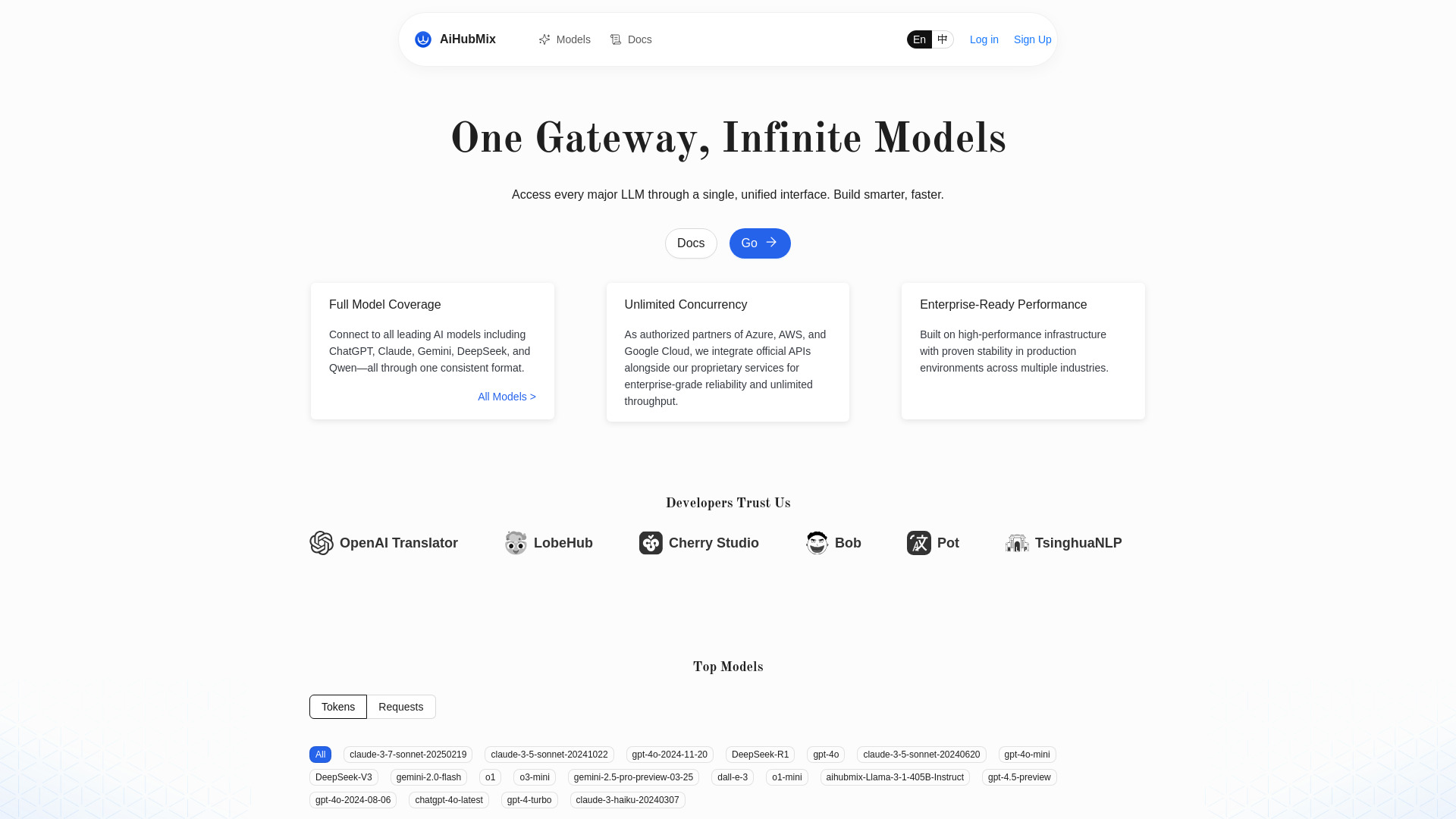

AiHubMix:一站式LLM API路由管理平台

引言

AiHubMix是一款创新的LLM API路由器,旨在为开发者和企业提供统一、高效的AI模型接入方案。通过聚合多种主流AI模型,并以标准OpenAI API格式提供服务,AiHubMix有效解决了多模型管理、成本控制和性能优化等核心问题,成为AI应用开发的强大助力。

功能特性

AiHubMix具备以下核心功能特性:

| 功能类别 | 具体描述 |

|---|---|

| 模型聚合 | 支持接入GPT、Claude、Llama等多种主流AI模型 |

| 统一接口 | 提供标准OpenAI API格式,无需修改现有代码 |

| 智能路由 | 根据请求类型、成本和性能自动选择最优模型 |

| 负载均衡 | 智能分配请求,避免单点过载,提升系统稳定性 |

| 成本控制 | 实时监控API调用成本,支持预算预警和限制 |

| 性能监控 | 提供详细的响应时间、成功率等性能指标 |

使用方法

使用AiHubMix非常简单,主要分为以下几个步骤:

注册与配置:在AiHubMix平台注册账号,完成基本配置

添加模型:根据需求添加所需的AI模型,配置相应的API密钥

设置路由规则:根据业务需求设置模型选择和路由规则

获取统一API:系统生成统一的OpenAI格式API端点

集成调用:将API端点集成到现有应用中,即可开始使用

示例代码:

python import openai 设置AiHubMix提供的统一API端点

openai.apibase = "https://api.aihubmix.com/v1" openai.apikey = "your-api-key" 标准OpenAI调用方式

response = openai.ChatCompletion.create( model="gpt-3.5-turbo", # AiHubMix会根据配置路由到实际模型 messages=[{"role": "user", "content": "Hello, world!"}] ) 应用场景

AiHubMix适用于多种应用场景:

- 企业AI应用开发:企业可利用AiHubMix快速构建基于多种AI模型的应用,无需为每个模型单独开发接口

- 模型对比与测试:研究人员和开发者可轻松对比不同模型在同一任务上的表现

- 成本敏感型服务:通过智能路由选择性价比最高的模型,有效控制API调用成本

- 高可用性系统:利用负载均衡和故障转移机制,确保AI服务的高可用性

- 多场景AI解决方案:针对不同业务需求,灵活配置最适合的AI模型

技术特点

AiHubMix在技术层面具有以下优势:

- 高性能架构:采用异步处理和连接池技术,确保高并发场景下的低延迟响应

- 智能缓存机制:对相似请求进行智能缓存,减少重复API调用,降低成本

- 安全可靠:提供API密钥加密存储、请求加密传输等安全措施

- 易于扩展:支持自定义模型接入和插件开发,满足个性化需求

- 全面监控:提供实时监控面板,帮助用户全面了解API使用情况

相关问题与解答

Q1: AiHubMix如何帮助企业降低AI应用开发成本?

A1: AiHubMix通过多种方式帮助企业降低成本:首先,智能路由功能可根据任务复杂度和预算自动选择最经济的模型;其次,内置的缓存机制减少重复API调用;再者,统一的API接口减少了开发和维护多模型适配的工作量;最后,详细的成本分析报告帮助企业优化资源分配,避免不必要的开支。

Q2: AiHubMix与直接使用单个AI模型API相比有哪些优势?

A2: 相比直接使用单个AI模型API,AiHubMix具有明显优势:一是提供多模型选择,避免对单一供应商的依赖;二是通过智能路由和负载均衡提升系统稳定性和响应速度;三是简化了多模型环境下的开发复杂度;四是提供统一的成本管理和性能监控;五是支持灵活的模型切换和A/B测试,使企业能够根据实际需求动态调整AI策略。