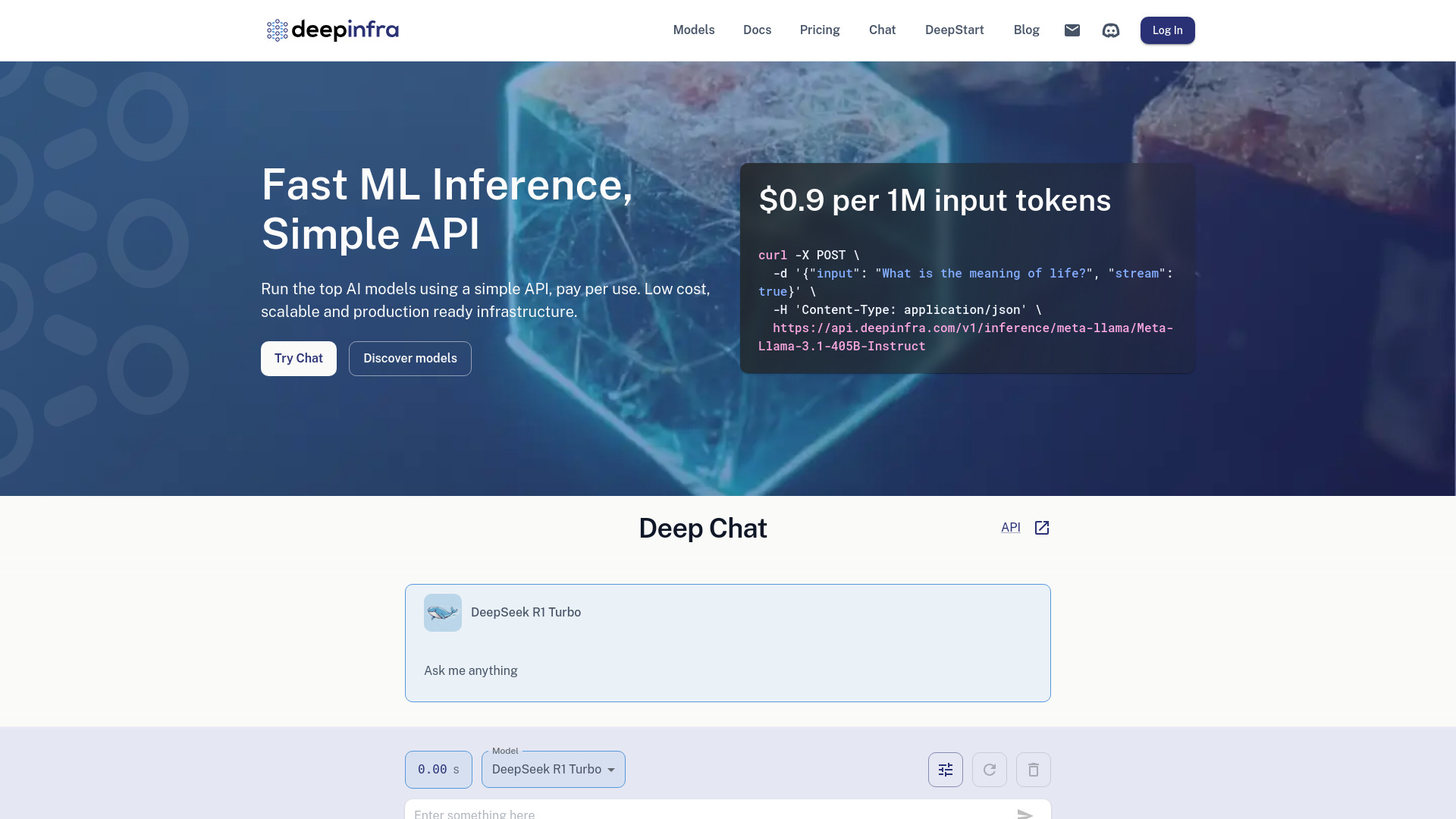

Deep Infra

详细说明

Deep Infra:高效便捷的机器学习模型部署平台

Deep Infra是一个专注于机器学习模型部署和运行的云平台,通过提供简洁的API接口和灵活的按使用付费定价模式,使开发者和企业能够快速、高效地将机器学习模型投入实际应用。本文将全面介绍Deep Infra的功能特性、使用方法、应用场景和技术特点,帮助读者了解如何利用这一平台简化机器学习模型的部署流程。

功能特性

Deep Infra提供了一系列强大的功能,使机器学习模型的部署变得简单高效。以下是平台的主要功能特性:

| 功能类别 | 具体特性 | 说明 |

|---|---|---|

| 模型部署 | 多框架支持 | 支持TensorFlow、PyTorch、Scikit-learn等主流机器学习框架 |

| 自动扩展 | 根据请求量自动调整计算资源,确保性能稳定 | |

| API接口 | RESTful API | 提供标准化的RESTful接口,便于集成到现有系统 |

| 实时推理 | 支持低延迟的实时模型推理服务 | |

| 计费模式 | 按使用付费 | 仅根据实际资源消耗计费,无需前期投入 |

| 透明定价 | 提供清晰的定价结构,便于成本控制 | |

| 管理工具 | 监控面板 | 提供实时性能监控和使用情况分析 |

| 版本管理 | 支持模型版本控制,便于回滚和更新 |

使用方法

使用Deep Infra部署机器学习模型的流程十分简便,主要分为以下几个步骤:

注册与认证:在Deep Infra官网创建账号并完成身份验证,获取API密钥。

模型上传:通过平台提供的界面或命令行工具上传训练好的模型文件,支持多种格式。

配置部署参数:设置模型名称、版本、计算资源配置(CPU/GPU)、内存需求等参数。

部署模型:点击部署按钮或通过API调用启动部署过程,平台会自动完成环境配置和模型加载。

测试与调用:使用提供的测试工具验证模型功能,通过RESTful API将模型集成到应用程序中。

监控与优化:通过监控面板查看模型性能指标,根据使用情况调整资源配置。

应用场景

Deep Infra适用于多种机器学习应用场景,以下表格展示了不同领域的典型应用:

| 应用领域 | 具体场景 | 模型类型 |

|---|---|---|

| 自然语言处理 | 智能客服、文本分析、机器翻译 | BERT、GPT、T5等大语言模型 |

| 计算机视觉 | 图像识别、目标检测、人脸识别 | CNN、YOLO、ResNet等视觉模型 |

| 推荐系统 | 个性化推荐、内容筛选 | 协同过滤、深度学习推荐模型 |

| 金融科技 | 风险评估、欺诈检测、量化交易 | 随机森林、梯度提升、时序模型 |

| 医疗健康 | 疾病诊断、药物发现、医学影像分析 | 深度学习、分类模型、分割模型 |

技术特点

Deep Infra在技术架构上具有以下显著特点:

高性能推理引擎:采用优化的推理引擎,通过模型量化、批处理和计算图优化等技术,显著提升推理速度,降低延迟。

弹性资源调度:基于容器技术和微服务架构,实现计算资源的动态分配和弹性伸缩,确保在高并发场景下的稳定性能。

安全与合规:提供数据加密、访问控制、审计日志等安全功能,符合GDPR、HIPAA等数据保护法规要求。

全球部署:支持多区域部署,用户可选择最近的数据中心以减少网络延迟,提高响应速度。

无缝集成:提供丰富的SDK和插件,支持与主流云服务、CI/CD工具和机器学习框架的无缝集成。

相关问题与解答

问题1:Deep Infra的按使用付费模式具体如何计费?是否有隐藏费用?

解答:Deep Infra采用透明的按使用付费模式,主要根据三个维度计费:计算资源使用时间(按秒计费)、数据传输量和API调用次数。平台不收取任何前期费用或长期合约费用,也没有隐藏费用。用户可以通过控制面板实时查看资源使用情况和费用明细,并设置预算警报以控制成本。对于长期高用量用户,平台还提供阶梯式折扣,使用量越大,单价越低。

问题2:Deep Infra如何保证部署模型的安全性和隐私保护?

解答:Deep Infra采用多层安全措施保护用户模型和数据的安全。首先,所有数据传输均通过TLS加密;其次,模型和数据在存储时采用AES-256加密;第三,平台提供细粒度的访问控制,用户可精确设置谁可以访问模型及其API;第四,Deep Infra定期进行安全审计和漏洞扫描,确保基础设施安全。此外,平台支持私有部署选项,满足对数据主权有严格要求的用户。所有这些措施均符合ISO 27001、SOC 2 Type II等国际安全标准。